完整文件:机器学习作业3

Regularized Logistic Regression

在这个实验中,是以Logistic回归作为基础,将再次复习Logistic回归,对Logistic回归将有更深的理解。通过对比未进行正则化的Logistic回归与正则化的Logistic回归在相同数据集上的表现来理解正则化缓解过拟合现象的作用。 注:本次实验不再给出理论结果,在你们的训练结果中需要看出加入正则项以后的结果变化。

1. 导入Python库

首先,我们导入这次实验所需要使用的Python库,以及辅助函数

In [ ]:

from google.colab import drive

drive.mount('/content/drive')

Mounted at /content/drive

In [1]:

import sys

from google.colab import drive

drive.mount('/content/drive')

sys.path.append('/content/drive/MyDrive/ML_HW/ML_HW3/HW3(2)')

Mounted at /content/drive

In [3]:

import numpy as np

import matplotlib.pyplot as plt

from utils import *

2. 知识回顾–过拟合问题分析

实际应用中容易出现过拟合,其原因则在于模型已经足够复杂,但是我们往往根本就不知道设计的模型的复杂程度是否刚好满足要求。

这就需要我们去判断模型是否刚刚好,如何判断是否出现了过拟合或欠拟合呢?我们一般通过将数据分为3个部分,训练集(train set),验证集(validation set)和测试集(test set)。所谓过拟合就是指模型的泛化能力不强,那么,我们就在验证集上测试模型的泛化能力。如下图所示,我们可以看到,过拟合的时候在验证集上表现不好(即泛化能力不强)。而对于欠拟合,往往在训练集上的表现就可以看出表现不好。

如何解决欠拟合和过拟合问题?

欠拟合(Large Bias): 增加模型的复杂度

- 收集新的特征

- 增加多项式组合特征

过拟合(Large Variance)

- 增加数据(very effective, but not always practical)

- 降低模型复杂度:

- 减少特征

- 正则化(Regularization):非常有效的方法,可大幅度降低方差(增加偏差)

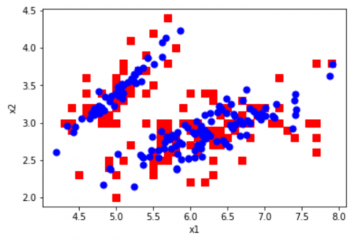

3. 可视化数据

为了方便可视化,我们选用二维的数据方便观察。接下来,我们导入这次实验需要用到的数据,并且对其进行可视化。 设为我们的特征矩阵,

为训练集里面的第

个样本,

为样本中的第

个特征,则:

为一个列向量,

代表第

个样本对应的标签,则:

这里我们已经将数据分成训练集(对应train.txt)和验证集(对应val.txt)。下面直观地观察一下训练集的数据分布。

In [4]:

train_data = np.loadtxt('/content/drive/MyDrive/ML_HW/ML_HW3/HW3(2)/train.txt')

val_data = np.loadtxt('/content/drive/MyDrive/ML_HW/ML_HW3/HW3(2)/val.txt')

X_train = train_data[:, 0:2].reshape(-1,2)

Y_train = train_data[:, 2]

X_val = val_data[:, 0:2].reshape(-1,2)

Y_val = val_data[:, 2]

print("The shape of X_train is:", X_train.shape)

print("The shape of Y_train is:", Y_train.shape)

plotData(X_train, Y_train)

The shape of X_train is: (150, 2)

The shape of Y_train is: (150,)

Out[4]:

<module 'matplotlib.pyplot' from '/usr/local/lib/python3.7/dist-packages/matplotlib/pyplot.py'>

4. Logistic与Regularized Logistic

现在的任务是使用Logistic对上面的数据集进行分类。根据2中分析,我们可以知道特征较少往往就不能很好拟合数据,而这里只有两个特征,所以这里我们先使用多项式来组合特征。

4.1 特征映射

上面的数据只有两个特征,和

,我们按照作业1里多项式回归的相同步骤,将

和

映射为最高为6次的多项式。即:

这里同作业1线性回归里一样为了方便处理偏置项,将两个特征映射成了

个特征。算上

则多项式回归的参数个数为

个。

In [5]:

map_X_train = mapFeature(X_train[:,0], X_train[:,1], degree=6)

print("After mapping the features, the shape of map_X_train is:", map_X_train.shape)

print(X_train[:2,:2])

print(map_X_train[:2,:])

After mapping the features, the shape of map_X_train is: (150, 28)

[[ 0.19 -0.12]

[ 0.13 0.03]]

[[ 1.0000000e+00 1.9000000e-01 -1.2000000e-01 3.6100000e-02

-2.2800000e-02 1.4400000e-02 6.8590000e-03 -4.3320000e-03

2.7360000e-03 -1.7280000e-03 1.3032100e-03 -8.2308000e-04

5.1984000e-04 -3.2832000e-04 2.0736000e-04 2.4760990e-04

-1.5638520e-04 9.8769600e-05 -6.2380800e-05 3.9398400e-05

-2.4883200e-05 4.7045881e-05 -2.9713188e-05 1.8766224e-05

-1.1852352e-05 7.4856960e-06 -4.7278080e-06 2.9859840e-06]

[ 1.0000000e+00 1.3000000e-01 3.0000000e-02 1.6900000e-02

3.9000000e-03 9.0000000e-04 2.1970000e-03 5.0700000e-04

1.1700000e-04 2.7000000e-05 2.8561000e-04 6.5910000e-05

1.5210000e-05 3.5100000e-06 8.1000000e-07 3.7129300e-05

8.5683000e-06 1.9773000e-06 4.5630000e-07 1.0530000e-07

2.4300000e-08 4.8268090e-06 1.1138790e-06 2.5704900e-07

5.9319000e-08 1.3689000e-08 3.1590000e-09 7.2900000e-10]]

4.2 sigmoid函数

我们打算使用Logistic回归训练一个模型,来区分我们的正类与负类,因此我们需要一个Sigmoid函数:

注意:我们写的Sigmoid函数是需要能够对矩阵直接进行操作的。

Hint:计算可以使用np.exp(-z)来进行计算

任务1:实现sigmoid函数

In [6]:

def sigmoid(z):

"""

对矩阵z中每个元素计算其Sigmoid函数值

"""

### START CODE HERE ###

g = 1/(1+np.exp(-z))

### END CODE HERE ###

return g

In [ ]:

print(sigmoid(map_X_train[1, :]))

[0.73105858 0.53245431 0.50749944 0.5042249 0.500975 0.500225

0.50054925 0.50012675 0.50002925 0.50000675 0.5000714 0.50001648

0.5000038 0.50000088 0.5000002 0.50000928 0.50000214 0.50000049

0.50000011 0.50000003 0.50000001 0.50000121 0.50000028 0.50000006

0.50000001 0.5 0.5 0.5 ]

4.3 初始化参数

为了简单我们初始化权重为零向量。

其中为特征的数量。

Hint:使用np.zeros()

任务2:初始化权重为零向量。

In [7]:

def init_parameter(n):

"""

初始化参数

:param n : map_X_train的列数

:return :权重向量

"""

### START CODE HERE ###

initial_theta = np.zeros(n)

### END CODE HERE ###

return initial_theta

In [ ]:

print("The initialized theta's shape is:",init_parameter(map_X_train.shape[1]).shape)

The initialized theta's shape is: (28,)

4.4 预测与计算loss

没有正则项的loss:其中,

有正则项的loss:

其中,是正则化项。

我们从上式中看到,将设置为

就可以将有正则项的loss转化为无正则项的loss。因此我们可以来设置

观察有正则和无正则的效果。

预测的时候对于有无正则项都是一样的。

Hint:

a = np.array([1,2,3,4])

a的平均值为a.mean()或者用a.sum()除以a的个数。

a = np.array([0.3,0.5,0.8]) a.round()

[0., 0., 1.]

其他一些函数可能会有用:np.dot(),np.log(),np.power()

任务3:完成计算loss的函数

注意:1.不要for循环求和。2.正则项loss不计算第一个权重

In [67]:

def loss(X, y, theta, lambd):

"""

计算loss

:param X:特征矩阵X

:param y:特征矩阵X对应的标签

:param theta:权重矩阵theta

:param lambd:正则化参数lambda

:return: loss

"""

### START CODE HERE ###

m = X.shape[0]

h = sigmoid(np.dot(X,theta)) #h函数

z = (lambd/2)*np.sum(np.power(theta[1:],2))/m #正则化项

J = -(np.multiply(y,np.log(h))+np.multiply((1-y),(np.log(1-h)))).mean()+z #J函数

### END CODE HERE ###

return J

In [68]:

test_X = np.array([0.1,0.2,0.3,0.4]).reshape(2,2)

test_y = np.array([0,1])

test_theta = np.array([0.5,0.6])

test_lambd = 1

print('test loss:',loss(test_X, test_y, test_theta, test_lambd))

test loss: 0.7393978677830249

任务4:预测分类的函数

In [69]:

def predict(X, theta):

"""

对数据矩阵预测类别

:param X:特征矩阵X

:param theta:权重矩阵theta

:return 由 0.,1.组成的向量,维度应该与X.shape[0]一致

"""

### START CODE HERE ###

h = sigmoid(np.dot(X,theta))

classes = h.round()

### END CODE HERE ###

return classes

In [70]:

test_X = np.array([-0.1,-0.2,-0.3,0.4]).reshape(2,2)

test_theta = np.array([0.5,0.6])

print('test predict:',predict(test_X, test_theta))

test predict: [0. 1.]

4.5 计算梯度

梯度计算公式如下(可以自己推导一下):

为了方便,我们可以先对所有

(包括

)用下面的式子求梯度,然后再给

的梯度减去

任务5:完成计算梯度的函数

Hint: 1. 矩阵A的转置为A.T 2. 的维度与

的维度是一样的 3.矩阵的长宽,或者说向量中的元素个数,可以通过

和

获得

In [80]:

def compute_grad(X, y, theta, lambd):

"""

计算梯度

:param X:特征矩阵X

:param y:特征矩阵X对应的标签

:param theta:权重矩阵theta

:param lambd:正则化参数lambda

:return : 对theta的梯度,维度应该与theta一致

"""

### START CODE HERE ###

m = X.shape[0]

h = sigmoid(np.dot(X,theta))

grad = np.dot(X.T,(h-y))/m+lambd/m*theta

grad[0] = grad[0]-(lambd/m*theta[0])

### END CODE HERE ###

return grad

In [81]:

test_X = np.array([0.1,0.2,0.3,0.4]).reshape(2,2)

test_y = np.array([0,1])

test_theta = np.array([0.5,0.6])

test_lambd = 1

print('test compute_grad:',compute_grad(test_X, test_y, test_theta, test_lambd))

test compute_grad: [-0.0334377 0.27349633]

4.6 更新参数

更新参数还是使用梯度下降法。公式如下:

任务6:完成更新参数的函数

In [82]:

def update_pameter(theta, gradients, learning_rate):

"""

更新参数theta

:param theta:权重theta

:param gradients:梯度值

:param learning_rate:学习速率

:return:更新后的theta

"""

### START CODE HERE ###

theta = theta - gradients*learning_rate

### END CODE HERE ###

return theta

In [83]:

test_X = np.array([0.1,0.2,0.3,0.4]).reshape(2,2)

test_y = np.array([0,1])

test_theta = np.array([0.5,0.6])

test_lambd = 1

test_grad = compute_grad(test_X, test_y, test_theta, test_lambd)

print('test update_pameter:',update_pameter(test_theta, test_grad, 1))

test update_pameter: [0.5334377 0.32650367]

4.7 搭积木

接下来,我们将上面的代码整合到我们的模型Model中,并且我们将记录下成本的变化过程。

任务7:完成训练模型函数。

In [84]:

def Model(X, y, theta, iteration=300000, learning_rate = 1, lambd = 0):

"""

Regulared Logistic Regression Model

:param X:输入X

:param y:标签Y

:param theta:参数theta

:param iteration:迭代次数

:param learning_rate:学习率

:param lambd:正则化参数lambda

:return:最终theta的值、theta的历史记录、loss的历史记录和精确度的历史记录

"""

theta_history = []

J_history = []

acc_history = []

for i in range(iteration):

### START CODE HERE ###

gradients = compute_grad(X, y, theta, lambd)

theta = update_pameter(theta, gradients, learning_rate)

### END CODE HERE ###

if i%10000==0:

J = loss(X, y, theta, lambd)

J_history.append(J)

pred = predict(X, theta)

acc_history.append((pred==y).mean())

theta_history.append(theta)

return theta,theta_history, J_history, acc_history

5.训练模型与分析

5.1 无正则项

无正则项只需设置即可,下面是无正则项时在训练集和验证集上的表现以及在训练集上的分类边界。

In [85]:

# 1. 特征映射

map_X_train = mapFeature(X_train[:,0], X_train[:,1], degree=6)

map_X_val = mapFeature(X_val[:,0], X_val[:,1], degree=6)

# 2. 初始化参数

theta = init_parameter(map_X_train.shape[1])

# 3. 训练

theta,theta_history, J_history, acc_history = Model(map_X_train, Y_train, theta, iteration=300000, learning_rate = 1, lambd = 0)

# 4. 验证集上验证

acc_val_history = []

J_val_history = []

for i in range(len(theta_history)):

acc_val = (predict(map_X_val, theta_history[i])==Y_val).mean()

acc_val_history.append(acc_val)

J_val = loss(map_X_val, Y_val, theta_history[i], 0)

J_val_history.append(J_val)

# 5. 分析

In [86]:

# 5.1 绘制分类边界

plotDecisionBoundary(X_train, Y_train,theta)

Out[86]:

<module 'matplotlib.pyplot' from '/usr/local/lib/python3.7/dist-packages/matplotlib/pyplot.py'>

In [87]:

# 5.2 比较预测精确度

plt.plot(acc_history,label='train')

plt.plot(acc_val_history,label='validation')

plt.legend()

Out[87]:

<matplotlib.legend.Legend at 0x7fe57eed3a90>

In [88]:

# 5.3 比较loss

plt.plot(J_history,label='train')

plt.plot(J_val_history,label='val')

plt.legend()

Out[88]:

<matplotlib.legend.Legend at 0x7fe57edd6e10>

从训练过程中的分类精确度分析可知,随着训练次数增加,在训练集上的精确度会进一步提升,但是在验证集上的精确度有轻微的下降。

从训练过程中的loss分析可知,随着训练次数增加,在训练集上的loss会进一步降低,但是在验证集上的loss会有些发散。

这些都说明了训练的模型已经过拟合,需要降低模型复杂度来提高泛化能力。

5.2 有正则项

这里设置,可以再提交作业后尝试设置不同的值观察结果。

In [89]:

# 1. 特征映射

map_X_train = mapFeature(X_train[:,0], X_train[:,1], degree=6)

map_X_val = mapFeature(X_val[:,0], X_val[:,1], degree=6)

# 2. 初始化参数

theta = init_parameter(map_X_train.shape[1])

# 3. 训练

theta,theta_history, J_history, acc_history = Model(map_X_train, Y_train, theta, iteration=300000, learning_rate = 1, lambd = 0.005)

# 4. 验证集上验证

acc_val_history = []

J_val_history = []

for i in range(len(theta_history)):

acc_val = (predict(map_X_val, theta_history[i])==Y_val).mean()

acc_val_history.append(acc_val)

J_val = loss(map_X_val, Y_val, theta_history[i], 0)

J_val_history.append(J_val)

# 5. 分析

In [90]:

# 5.1 绘制分类边界

plotDecisionBoundary(X_train, Y_train,theta)

Out[90]:

<module 'matplotlib.pyplot' from '/usr/local/lib/python3.7/dist-packages/matplotlib/pyplot.py'>

In [91]:

# 5.2 比较预测精确度

plt.plot(acc_history,label='train')

plt.plot(acc_val_history,label='validation')

plt.legend()

Out[91]:

<matplotlib.legend.Legend at 0x7fe57ed48990>

In [92]:

# 5.3 比较loss

plt.plot(J_history,label='train')

plt.plot(J_val_history,label='val')

plt.legend()

Out[92]:

<matplotlib.legend.Legend at 0x7fe57ecc9790>

对比无正则项的实验结果,我们可以发现有正则项的模型明显提升了泛化能力,过拟合的现象大大减小。

6 总结

通过这次实验,我们能够直观的理解正则化对于缓解过拟合现象所起到的作用。在提交完作业后,你还可以试试不同的值,观察决策边界的变化。

0 条评论